|

SOMMARIO

- Questo studio

presenta l'evoluzione della produzione sociale basata su beni comuni (commons-based

peer production) analizzandone, attraverso alcuni casi reali, l'impatto

su neutralità della rete e diritto d'autore.

- Le misurazioni

presentate comprendono siti come Suprnova.org, Youtube.com, Facebook.com,

e sistemi peer-to-peer (P2P) come Kazaa, Bittorrent, and Tribler.

- Tali misurazioni

mostrano i due aspetti della produzione sociale, quello "pirata"

attraverso il quale questi sistemi P2P offrono la gratuita disponibilità

di film di Hollywood, e quello "samaritano", rappresentato dalla

rapida adesione di oltre 400.000 persone ad una comunità per organizzare

proteste contro gli eventi in Birmania.

- Il panorama

delle telecomunicazioni e della produzione di contenuti é sconvolto

da queste modalità di produzione orizzontale: é dunque probabile

che i ricavi delle rispettive industrie possano risentirne nel corso dei

prossimi anni.

- È anche

possibile che sistemi innovativi di P2P potranno vincere la battaglia contro

le più classiche tecnologie di distribuzione: si prevede pertanto

una continuazione delle azioni legali e tecniche volte a bloccare tale

traffico, anche in violazione della neutralità della rete.

- L'argomento

proposto dagli autori è che un approccio restrittivo ostacola l'innovazione

e provoca una grande discrepanza tra gli ordinamenti giuridici e le prospettive

degli utenti.

- Una riforma

delle leggi sul copyright è pertanto necessaria: in mancanza di

tale riforma le norme correnti risulteranno di fatto inapplicabili intorno

al 2010.

1.

INTRODUZIONE

- Ora che un miliardo

di persone sono connesse tramite l'Internet, la loro forza creativa combinata

sorpassa quella di qualunque industria. Nella rete il ruolo dei produttori

e dei consumatori sta cominciando a sfocarsi e a fondersi, in un'evoluzione

che è ben descritta dal termine prosumer (produttore-consumatore,

dall'inglese producer-consumer) (Toffler 1980).

- La crescita

delle attività prosumer sta cambiando il paesaggio del mondo del

business. Yochai Benkler ha descritto questo fenomeno come "il terzo

modo di produrre", separandolo così dai modelli tradizionali

di stato e mercato (Benkler 2002).

- Benkler ha per

l'appunto coniato il termine produzione sociale per descrivere questa nuova

forma di creazione di contenuti da parte di prosumer. In generale, in letteratura

tutti i concetti e gli esempi di produzione sociale si concentrano su ciò

che è qui definito come il lato samaritano della stessa: esiste

tuttavia anche un lato oscuro e dirompente, vale a dire il lato pirata,

che verrà discusso nella Sezione 2.

- In questo articolo

vengono presentate misurazioni relative a piattaforme per il peer-to-peer

(P2P) che permettono a grandi gruppi di prosumer di impegnarsi nella produzione

sociale.

- Un concetto

chiave di questa tecnologia è dato dalla sua natura decentralizzata,

che si traduce nella mancanza di una qualsiasi singola persona, autorità

o computer centrale che sia responsabile del sistema, da qui il termine

di peer-to-peer.

- Le misurazioni

disponibili consentono di caratterizzare lo sviluppo di piattaforme P2P

degli ultimi dieci anni (Sezione 3) e di coprire una vasta gamma

di argomenti, quali il comportamento nel cambiare il canale TV, la condivisione

di file usando il P2P, l'amicizia all'interno delle comunità di

Internet, ed i sistemi basati sul concetto di reputazione. I dati raccolti

indicano che la produzione sociale sta crescendo in quattro direzioni:

- i) un maggior

numero di persone sta utilizzando prodotti creati utilizzando la produzione

sociale basata su beni comuni

- ii) la produzione

creativa di massa è in aumento,

- iii) il grado

di sofisticazione delle piattaforme P2P sta migliorando rapidamente, e

- iv) i tipi di

prodotti offerti sono in espansione (ad esempio, prestito di denaro P2P)

(Manjoo 2006).

- Questo studio

affronta due aspetti della produzione sociale. Il primo aspetto è

quello volto a capire e quantificare i meccanismi sottostanti la produzione

sociale, individuando punti di forza, debolezze, e le condizioni che le

consentono di prosperare.

- Il secondo aspetto

riguarda l'influenza della produzione sociale su convergenza, neutralità

della rete, diritto d'autore, e sulla società in generale.

2.

LA FORZA DIROMPENTE DELLA PRODUZIONE SOCIALE

- La produzione

sociale può avere un grande impatto sugli attuali modelli di business.

Il rilascio del potere collettivo di grandi gruppi di utenti impegnati

nella produzione di massa è un cambiamento dirompente per la generazione

dei contenuti, per le telecomunicazioni e per gli altri settori industriali

coinvolti.

- In alcuni casi

l'offerta di una società può anche essere fornita a costo

zero da parte di un gruppo di volontari organizzati. In questa sezione

evidenziamo la forza dirompente della produzione sociale. Il primo esempio

è il sito web Wikipedia.org, in cui gli utenti collaborano per creare

un'enciclopedia che può essere scaricata e utilizzata gratuitamente.

- La qualità

di questa enciclopedia è stata valutata come circa uguale a quella

dell'Enciclopedia Britannica Online (Giles 2005). La pubblicazione

di tale valutazione è stata seguita da una significativa copertura

mediatica e si è scontrata con gravi critiche (ad esempio è

stata giudicata come "sbagliata e fuorviante" [Nota 1]

).

- Wikipedia è

oggi uno dei 10 siti più visitati al mondo, mentre Britannica.com

si colloca nella parte inferiore della classifica Top-5000 formulata dalla

società di monitoraggio Alexa.com: questo è un esempio di

effetto dirompente associato alla produzione sociale.

- Il secondo esempio

mostra la perturbazione causata dalla tecnologia P2P, che può essere

considerata come la compagna naturale della produzione sociale. Il P2P

sostituisce il tradizionale modello di Internet, in cui l'utente consuma

risorse di server centralizzati, con il modello prosumer, in cui l'utente

contribuisce sia il contenuto che le risorse hardware, eliminando così

la necessità di un server centrale.

- A questo proposito,

la condivisione di files P2P può essere considerata come una forma

di produzione sociale, dove dei produttori-consumatori si scambiano dei

contenuti (Pouwelse et al. 2005).

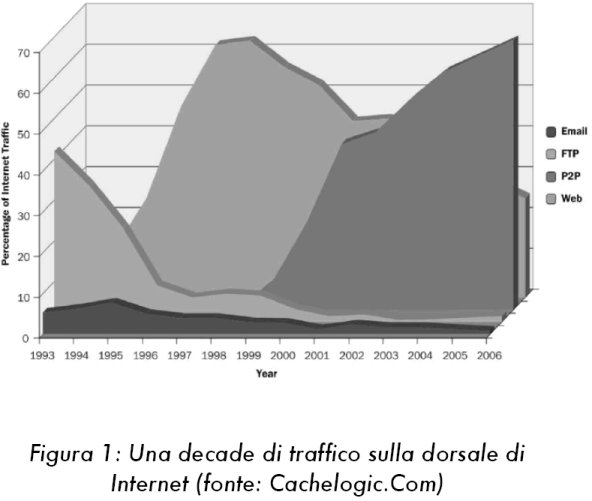

- Le misurazioni

del traffico Internet confermano che la condivisione di file P2P è

l'applicazione killer se si prende come parametro di osservazione il consumo

di banda trasmissiva. CacheLogic (cachelogic.com) ha esaminato i tipi di

traffico sulla dorsale di Internet nel periodo 1993-2006, ed i risultati

sono mostrati in Figura 1.

- Nei primi anni

1990, il protocollo Internet dominante è stato FTP. A metà

1990, il traffico FTP è stato superato dalla navigazione web.

- L'emergente

tecnologia P2P ha praticamente raddoppiato ogni anno la sua quota di traffico

nella dorsale di Internet, diventando il protocollo più popolare,

in termini di volume di traffico, dopo soli quattro anni di esistenza.

- Nel 2006, il

traffico P2P è stato responsabile per oltre due terzi di tutto il

traffico Internet, superando di quasi tre volte la navigazione sul web.

Una misurazione effettuata in Germania da ipoque.com ha mostrato come oltre

il 71% di tutto questo traffico P2P sia costituito da video. Un ulteriore

studio effettuato nel Regno Unito (Nielsen 2006) ha mostrato come "più

di due terzi dei cittadini britannici collegati alla rete hanno osservato

una qualche forma di contenuti video attraverso Internet".

- Sia i video

streaming che quelli scaricabili risultano essere popolari: in un'altra

misurazione Ellacoya.com ha rilevato che lo streaming video HTTP rappresentava

il 36% del traffico web.

- Da queste varie

misure, si può concludere che numerosi utenti di Internet guardano

video online e che la visione di questi video, trasportati da HTTP e da

protocolli P2P, domina il traffico Internet.

- Perché

la gente utilizza i contenuti video attraverso la rete, invece che attraverso

infrastrutture più tradizionali? Una risposta è che i video

su Internet sono spesso gratuiti, non sono legati ad orari di trasmissione

(video a richiesta), sono spesso privi di interruzioni pubblicitarie e,

nel caso del P2P, è possibile che non siano ancora (o non siano

più) disponibili nei cinematografi.

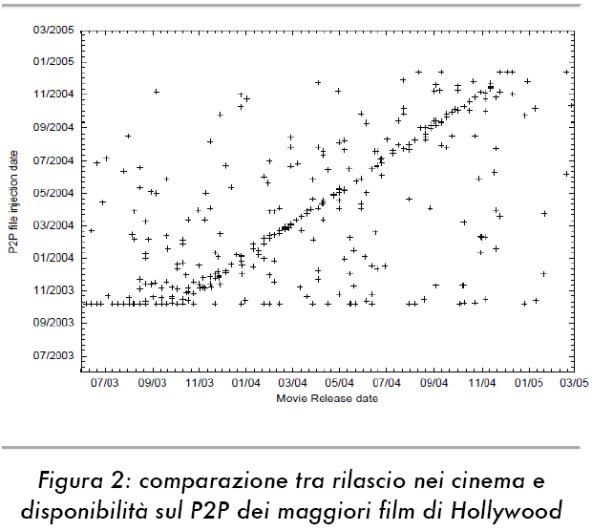

- Per quantificare

la forza dirompente della produzione di massa nel rendere disponibili i

più popolari film di Hollywood, si può prendere come riferimento

il portale P2P leader del 2004, suprnova.org.

- Sul quel sito

gli utenti hanno potuto trovare una grande ricchezza di contenuti con la

possibilità di effettuare lo scaricamento P2P con un solo clic.

Il sistema ha raggiunto un livello di popolarità di circa 800.000

visitatori univocamente identificati al giorno.

- Utilizzando

tecniche di scansione dei siti web, sono state ottenuti elenchi dettagliati

di tutti i file pubblicati attraverso Suprnova (Pouwelse et al. 2005).

- Tali elenchi

catturano l'intero ciclo di vita di Suprnova, dalla sua creazione, agli

inizi del 2003, fino alla sua chiusura (forzata) verso la fine del 2004.

L'insieme di dati raccolti contiene i nomi dei file che corrispondevano

ai nomi dei mille film più popolari di Hollywood di quegli anni.

- Questa corrispondenza

non è banale, poiché i nomi dei file sono copie letterali

del titolo del film solo in rari casi. Per facilitare questa attività

di riconoscimento è stato sviluppato un software che utilizza varie

regole per il consolidamento degli elenchi (ad esempio, "parte II"

equivale a " 2"), una funzione di valutazione per scegliere l'accoppiata

più adatta tra diverse alternative ed una tecnica di accoppiamento

di stringhe basata sulla distanza di Damerau-Levenshtein [Nota 2].

- La Figura 2

mostra la disponibilità di film di Hollywood sul portale Suprnova.

I risultati coprono il periodo di tempo a partire dal 2003 fino alla fine

del 2004. L'asse orizzontale rappresenta la data di uscita ufficiale di

film nei cinema degli Stati Uniti. L'asse verticale indica la data in cui

i file corrispondenti ai titoli dei film sono stati caricati su Suprnova.

- Tale figura

permette di conoscere sia il numero di titoli di Hollywood che sono stati

resi disponibili per il download che il tempo di disponibilità.

La correlazione tra il tempo di rilascio dei film ed il tempo di "iniezione"

nel circuito P2P è osservabile come una linea irregolare che va

dal basso a sinistra verso l'alto a destra.

- Lavori precedenti

avevano esaminato un campione di 183 film e ha rilevato che il 77% erano

stati rilasciati in maniera non autorizzata da addetti ai lavori dell'industria

cinematografica (Byers et al. 2004).

- Le misurazioni

rendono evidente che, per un numero significativo di titoli, gli utenti

non devono più attendere la trasmissione televisiva né il

rilascio nei teatri, poiché la disponibilità nei circuiti

P2P anticipa il rilascio attraverso i canali ufficiali.

- Siccome si è

stimato che il costo di esercizio di Suprnova sia stato inferiore a $500

al mese, si può concludere che la collaborazione tra prosumer per

la distribuzione di contenuti video sta dimostrando di essere efficace,

popolare, efficiente in termini di costi e dirompente rispetto ai modelli

di business esistenti.

3.

L'EVOLUZIONE DELLE PIATTAFORME P2P

- In questa sezione

è presentata un'analisi quantitativa dell'evoluzione delle piattaforme

P2P. Una piattaforma P2P è definita come un "meccanismo abilitante,

privo di un'autorità centrale, per consentire l'interazione umana

e la cooperazione su scala illimitata tramite mutua donazione di risorse

di calcolo e comunicazione".

- L'analisi si

sviluppa analizzando sette casi relativi alle piattaforme P2P, ognuna delle

quali rappresenta un passo nell'evoluzione di queste piattaforme. Un attento

studio di questa evoluzione ci porta a credere che piattaforme P2P efficaci

siano caratterizzate dai seguenti quattro elementi cardinali:

- (1) La capacità

di distinguere i contributi buoni da quelli cattivi;

- (2) Un meccanismo

di regolazione per le risorse del computer;

- (3) Buoni meccanismi

per la comunicazione di gruppo;

- (4) Un senso

di comunità.

- Per quanto riguarda

la prima di queste caratteristiche, il contributo è considerato

l'elemento elementare della collaborazione effettuata da un singolo prosumer.

Un contributo può avere la forma, per esempio, di un commento di

poche righe, un giudizio di qualità, oppure di un clip video. Tuttavia,

alcuni contributi contengono errori o sono semplicemente spam.

- La seconda caratteristica

serve a garantire che sufficienti risorse del computer siano mantenute

disponibili per eseguire il software P2P e memorizzare i dati contribuiti.

- Il terzo aspetto

riguarda la creazione di canali di comunicazione per consentire ai prosumer

plasmare i loro contributi.

- La quarta caratteristica

è l'esigenza di una visione e di una cultura condivisa al fine di

garantire la sostenibilità a lungo termine. Un senso di comunità

è di vitale importanza per superare le differenze di opinione. Le

comunità forniscono anche un senso di appartenenza ed incentivi

per motivare i volontari.

- Questa quarta

caratteristica cardinale è stata studiata nel contesto di problemi

di azione collettiva e di formazione di gruppo (Cornes and Sandler 1996).

3.1.

Primi contenuti generati dagli utenti e sistemi di moderazione

- Le piattaforme

P2P hanno una storia di circa dieci anni, a partire dalla creazione del

sito Slashdot.org nel 1997.

- Questo sito

ha rappresentato il primo caso di grandi dimensioni di generazione di contenuti

e di moderazione da parte dagli stessi utenti. Slashdot è ormai

da molti anni una fonte molto popolare di notizie sulla tecnologia.

- Esso non solo

presenta le notizie, ma soprattutto è stato un pioniere nella costruzione

di una comunità auto-regolata di prosumer, tramite aree di discussione

centrate sulla notizia.

- La novità

introdotta consisteva appunto nel fatto che il dibattito è moderato

dagli utenti stessi. Gli utenti di Slashdot hanno la possibilità

di allegare liberamente dei commenti ai singoli articoli. Tali commenti

contengono osservazioni, miglioramenti e approfondimenti sulle corrispondenti

notizie.

- Slashdot utilizza

un sistema di classificazione basato su voto e reputazione dell'utente

per la determinazione di un punteggio associato ad ogni commento. Il punteggio

varia da 1 (inferiore) a 5 (penetrante).

- Gli utenti ricevono,

in maniera casuale, la possibilità di moderare i commenti diminuendo

(-1) aumentando (+1) punteggi. L'iniziale punteggio attribuito ai commenti

è pari a 1 per gli utenti registrati e 0 per i commenti anonimi.

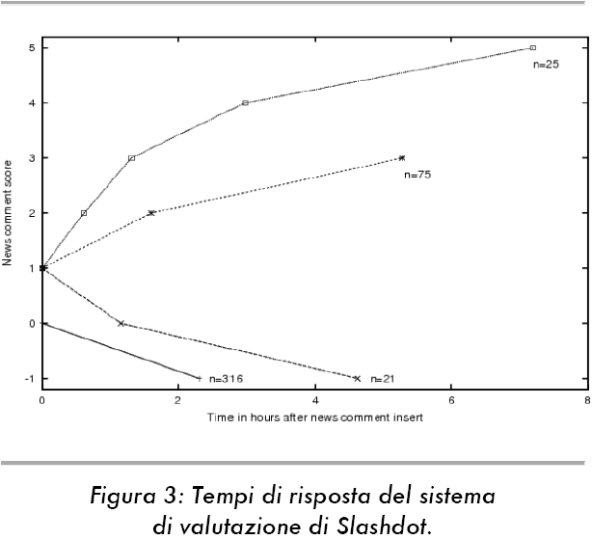

- Nel maggio 2000

abbiamo misurato la risposta del moderatore di Slashdot a 30 notizie che

hanno ricevuto 4250 commenti e 1400 moderazioni.

- La figura 3

mostra la durata media del processo di moderazione, dall'inserimento fino

alla ricezione del punteggio finale. Il punteggio iniziale di quasi l'80%

dei commenti non ha subito cambiamenti. Per gli altri, sono bastati 37

minuti prima che osservazioni successivamente valutate come "penetranti"

ottenessero il primo incremento del giudizio.

- I risultati

dimostrano che questo processo di moderazione collaborativa è rapido

e molto reattivo. Nel giro di alcune ore i buoni contenuti sono separati

da quelli cattivi, come indicato dalla rapida identificazione di commenti

spam anonimi.

- È da

notare come that Slashdot, che rappresenta la prima fase della evoluzione

del P2P, manchi di due dei quattro elementi cardine: gli utenti di Slashdot

non possono organizzarsi in gruppi o comunità, le funzioni di collaborazione

sono ancora elementari, e le risorse necessarie per far funzionare il sistema

sono fornite da ricavi pubblicitari.

3.2.

Proprietà pubblica di contenuti generati dagli utenti

- In Slashdot

i commenti vengono generati dagli utenti, ma appartengono ai proprietari

del sito. Il secondo passo nell'evoluzione delle piattaforme P2P rappresenta

invece la transizione verso la proprietà comunitaria dei contenuti,

in cui il contenuto è reso disponibile con un diritto d'autore simile

alla licenza per il software Open Source.

- L'esempio più

sofisticato dal 1999 è il sito web Musicbrainz.org. Il sito web

Musicbrainz è la patria di una comunità che costruisce un'enciclopedia

musicale attraverso attraverso un sito che raccoglie informazioni sugli

artisti, le loro opere, paesi di origine, le relazioni tra gli artisti,

date di rilascio di album e canzoni, eccetera. Musicbrainz a tutto maggio

2008 conteneva 380.000 nomi di artisti e 6.710.000 brani musicali.

- Fatto ancora

più rilevante, più di 389.000 volontari hanno inserito contenuti

in questa banca dati e corretto errori di ortografia usando un sistema

avanzato di voto e moderazione. Rispetto a Slashdot è chiaro che

il funzionamento del processo di moderazione in Musicbrainz ha maggiore

complessità e sofisticazione.

- Questo sistema

presenta in forma basilare tutte e quattro le caratteristiche cardinali

di una piattaforma P2P: un processo di voto, un fondo per la raccolta di

donazioni volontarie per il funzionamento del sito web, una mailing list

dedicata alla costruzione del consenso, e una visione condivisa, come indicato

nel corrispondente contratto sociale (Musicbrainz 1999).

3.3.

Valorizzare le risorse donate

- Il sistema per

la condivisione di file P2P Kazaa, lanciato nel marzo 2001, permette lo

scambio di file multimediali tra prosumers senza la mediazione di un server

e può essere considerato la terza tappa nell'evoluzione delle piattaforme

P2P (Leibowitz, Ripeanu, e Wierzbicki 2003).

- All'inizio del

2003 abbiamo condotto una serie di misurazioni, esaminando la regolazione

della banda trasmissiva nella rete di Kazaa. Come regola generale, ogni

file scaricato deve essere prima caricato da un altro utente. Il fattore

di condivisione di riferimento, pari a 1, è realizzato dagli utenti

che donano la stessa quantità di larghezza di banda che consumano.

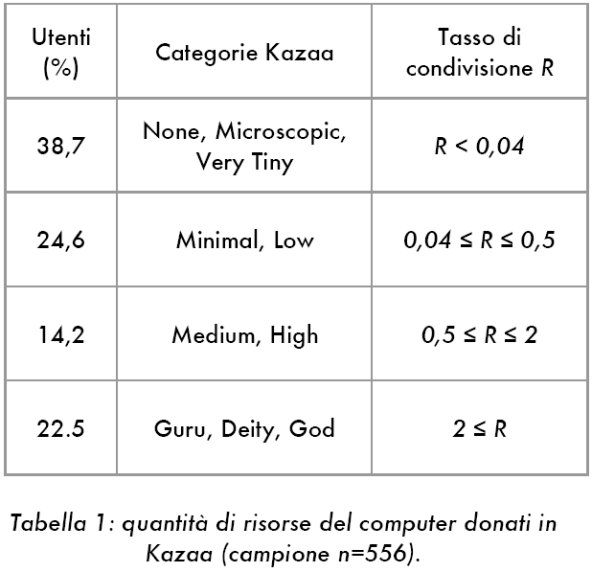

- La maggior parte

degli utenti consumano molto più banda trasmissiva di quella che

contribuiscono. Questo problema è noto come "freeriding"

(Adar e Huberman 2000).

- La tabella 1

mostra i rapporti di condivisione di un campione di 556 utenti di Kazaa

(rapporto tra bytes caricati e bytes scaricati). Una piccola minoranza

di prosumer (22,5%), classificati nell'interfaccia utente di Kazaa come

"Deity" e "God", sono responsabili per la maggior parte

delle donazioni di banda trasmissiva.

- A causa del

freeriding, la prestazione del sistema associata allo scaricamento di files

risulta notevolmente degradata. Il caso Kazaa dimostra la necessità

di disporre di un robusto meccanismo per assicurare la donazione di una

quantità sufficiente di risorse. Nel caso ideale, dovrebbe essere

creata un'economia delle risorse priva di perdite, in cui ogni prosumer

é vincolato a donare risorse almeno pari al suo consumo della risorsa

collettiva.

- Anche questo

problema può ancora essere visto come una necessità di assicurare

la separazione del bene dal male (in questo caso il fenomeno dei "freerider").

Kazaa rappresenta un primo passo verso la regolamentazione distribuita

delle risorse donate, aderendo alla seconda caratteristica cardinale delle

piattaforme P2P efficaci.

3.4.

Regolazione delle donazioni di capacità trasmissiva

- Il problema

del "freeriding" riscontrato in Kazaa è stato affrontato

nella progettazione del protocollo Bittorrent (Cohen 2003), un protocollo

per il download di file P2P che prevede incentivi alla donazione di banda

trasmissiva. Il meccanismo di incentivazione di Bittorrent è costruito

su un'economia di baratto dei dati.

- Più precisamente,

Bittorrent si avvale di una variante del meccanismo tit-for-tat per legare

la velocità di scaricamento dei contenuti al valore dei contributi

attuali. Con tit-for-tat gli utenti si scambiano (barattano) contenuti

locali in cambio di contenuti che desiderano ottenere da altri utenti.

Bittorrent è solo un protocollo per scaricare contenuti: la funzionalità

di ricerca dei contenuti, indispensabile a fornire una soluzione completa

per la condivisione di file, deve essere fornita mediante di servizi esterni.

- Un esempio ben

noto di un servizio di ricerca contenuto è il sito Suprnova già

descritto in dettaglio nella sezione 2.

- Bittorrent/Suprnova

rappresenta un passo avanti nel passaggio da un approccio monolitico verso

una soluzione a due livelli. Questo approccio ha consentito l'evoluzione

indipendente del protocollo di trasferimento dei contenuti e della funzionalità

di ricerca.

- Il sistema decentralizzato

Kazaa é però presto entrato in sofferenza a causa di spam

ed inquinamento dei contenuti. Suprnova reagito facendo un passo indietro

nell'evoluzione ed ha quindi introdotto un gruppo di server web replicati

con un sistema di moderazione basato sui prosumer.

- Per mantenere

"puliti" i contenuti, i nuovi contributi venivano prima ispezionati

manualmente dai moderatori, con l'obiettivo di eliminare i contenuti falsi,

quelli di bassa qualità e quelli con errori di denominazione. I

normali utenti che inviano dei contenuti sono soggetti al meccanismo di

moderazione.

- Per ridurre

l'onere associato a tale processo di moderazione, gli utenti che inseriscono

contributi corretti in maniera frequente sono promossi al rango di contributore

non moderato ed autorizzati ad aggiungere direttamente i contenuti. I contributori

non moderati possono comunque richiedere di essere promossi allo stato

di moderatore.

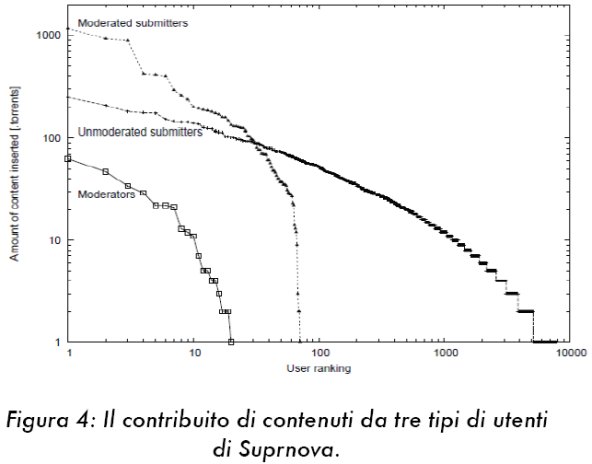

- La Figura 4

mostra la quantità di contenuti pubblicati dalle tre tipologie di

utenti (moderati, non moderati, moderatori) ricavato dai dati raccolti

da Bittorrent/Suprnova.

- L'asse orizzontale

presenta gli utenti, ordinati secondo la quantità di contenuti inseriti.

L'asse verticale indica la quantità di contenuti che essi hanno

inserito in Supernova.

- Il case study

Bittorrent/Suprnova evidenzia le difficoltà nel costruire un sistema

di condivisione dei contenuti scalabile ed immune da spam. Bittorrent affronta

la seconda caratteristica cardinale fornendo incentivi al caricamento di

dati, ma anche questo approccio non è a prova di frode (Piatek et

al. 2007).

3.5.

Interazione comunitaria

- Youtube.com,

attualmente il più grande sito per la pubblicazione di clip video,

rappresenta il quinto passo nell'evoluzione delle piattaforme P2P.

- Sotto molti

punti di vista, l'architettura Youtube rappresenta un passo indietro nell'evoluzione

delle piattaforme P2P: ad esempio, tutte le funzionalità del sistema

sono fornito attraverso un unico sito web che esegue il software proprietario.

Inoltre, analogamente a Slashdot, i contributi degli utenti sono soggetti

a clausole restrittive del diritto d'autore.

- Le limitazioni

architetturali e sul diritto d'autore di Youtube sono però compensate

dalla ricchezza della sua funzionalità comunitaria.

- Con l'aiuto

di un supercomputer abbiamo esplorato, a partire dall'estate del 2006,

oltre 5 milioni di pagine web di Youtube. Questa scansione contiene numerose

dettagliate informazioni sugli utenti, come la loro età ed il paese

di origine, l'ultimo collegamento, il loro elenco di clip video preferiti

ed i loro amici Youtube.

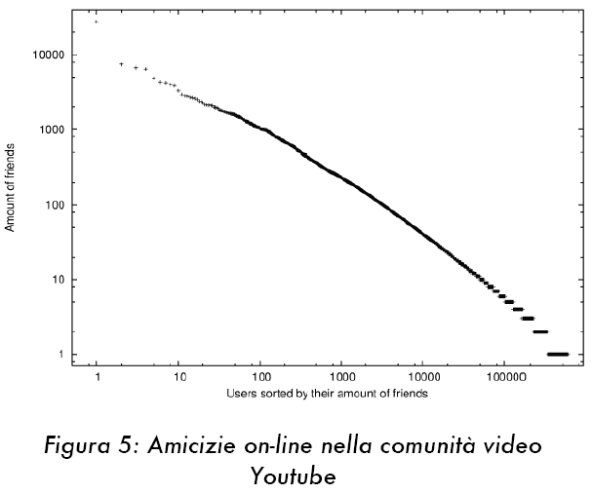

- La figura 5

mostra, per un campione di 592.900 utenti, quanti amici abbiano su Youtube.

L'asse orizzontale mostra i vari utenti ordinati in base al loro numero

di amici (asse verticale). L'utente più a sinistra in questa immagine

ha 27.716 "amici".

- La dimensione

della rete sociale catturata nellle misurazioni indica che con Youtube

il terzo e il quarto elemento cardinale delle piattaforme P2P sono stati

sviluppati fino a raggiungere un livello di sofisticazione superiore.

- La semplicità

e facilità d'uso di Youtube è una delle forze trainanti dietro

il suo successo.

- Il costo di

funzionamento del grande numero di server che costituiscono Youtube deve

essere in qualche modo recuperato con annunci pubblicitari mirati. Google

ha acquisito YouTube per 1.650 milioni di dollari ed i ricavi presenti

e futuri sono al centro di grande speculazione [Nota 3].

- Resta da vedere

se questo approccio possa competere con la condivisione di file P2P e possa

sostenere caratteristiche nuove e costose, come il formato HDTV.

3.6.

Produzione sociale di nuove funzionalità

- Il sito Facebook.com

porta le piattaforme P2P ad un nuovo livello, e costituisce il sesto passo

dell'evoluzione delle piattaforme P2P. Facebook è un sito web che

consente la creazione di reti sociali, comunità di interesse speciale,

e ricco contenuto multimediale.

- L'elemento chiave

è che Facebook permette ai prosumer di migliorare ed espandere le

funzionalità della piattaforma con la creazione di "applicazioni

prosumer". Tutte le applicazioni prosumer disponibili possono essere

viste attraverso un menu di navigazione. Un utente può installare

applicazioni prosumer con pochi clic di mouse.

- Durante la procedura

di installazione un utente concede diritti di accesso all'applicazione

prosumer. La nuova applicazione può quindi accedere alla lista di

amici, inviare messaggi, e si può aggiungere alla pagina principale

dell'utente Facebook. Al 27 settembre 2007 erano disponibili 4.626 di tali

applicazioni, che erano diventate 6.049 quattro settimane più tardi.

Questa crescita di 355 applicazioni alla settimana indica che Facebook

è una fiorente comunità che si espande attivamente.

- Una scoperta

chiave è stata l'esistenza di una "applicazione spam"

su Facebook. Ad esempio, l'applicazione chiamata "Sarai un multimilionario?"

forza l'utente ad inviare un messaggio personale ai suoi amici, chiedendo

anche a loro di installare questa applicazione. L'applicazione spam tenta

di diffondersi in maniera virale attraverso la rete sociale, guadagnando

l'accesso a informazioni personali, con l'obiettivo di generare un reddito

da pubblicità mirata, senza offrire reale funzionalità.

- Le osservazioni

indicano che la produzione sociale si é espansa dalle origini nelle

comunità tecnologiche (ad esempio, Slashdot) ad altri settori della

società. Le dinamiche di utilizzo di piattaforme P2P in altri settori

della società sono illustrate nell'esempio dalle sollevazioni in

Birmania.

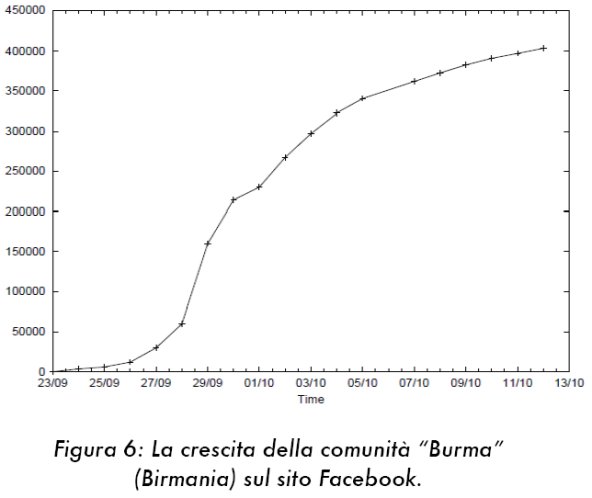

- La comunità

Facebook denominata "Supporto alla protesta dei monaci in Birmania"

è cresciuta a più di 400.000 membri in meno di 20 giorni.

- La Figura 6

mostra la velocità di crescita di questa comunità. L'asse

orizzontale mostra il numero di giorni dalla fondazione della comunità

e l'asse verticale mostra la dimensione della comunità.

- La crescita

massima si è verificata il 29 settembre 2007, con 100.000 nuovi

membri in un unico giorno. Si può concludere che Facebook rappresenta

un passo avanti nell'evoluzione di comunità prosumer con impatto

sulla società.

3.7.

Reputazione e comunità decentrate

- Il sistema di

condivisione di file P2P Tribler (Pouwelse et al. 2008) può

essere considerato come il settimo passo dell'evoluzione delle piattaforme

P2P. Tribler comprende un sistema di reputazione per il calcolo della "bontà"

degli altri utenti.

- Sistemi di reputazione

come quelli utilizzati sul sito di aste Ebay.com si sono dimostrati difficili

da realizzare in un'impostazione P2P (Sarkio 2006, Kamvar, Schlosser

e Garcia-Molina 2003).

- Tribler è

il primo sistema a introdurre un sistema decentrato per la valutazione

della reputazione degli utenti. Nei suoi aspetti progettuali, Tribler è

l'esatto contrario di Youtube and Facebook in quanto è priva di

qualsiasi punto centrale, è senza scopo di lucro, utilizza licenze

Open Source, e sfrutta un modello aperto per lo sviluppo del software.

In Tribler giocano un ruolo centrale i suoi aspetti sociali, la sua compatibilità

con Bittorrent, e la ricerca veloce di contenuti tramite parola chiave.

- Il sistema di

reputazione di Tribler si fonda sulla "bontà" degli altri

utenti in termini di affidabilità, di contenuti preferiti e di condivisione

di banda trasmissiva. L'informazione sulla bontà è legata

ad un identificativo a chiave pubblica immagazzinato in un database chiamato

MegaCache. Un agente Tribler esplora costantemente la rete P2P, alla ricerca

di contenuti freschi e di persone, facendo una nuova connessione ogni pochi

secondi secondo un protocollo epidemico (Pouwelse et al. 2008).

- La somiglianza

delle preferenze di download dei vari utenti è determinata utilizzando

tecniche di filtraggio collaborativo. Utenti con gusti simili sono una

considerati "migliori" e ri-contattati periodicamente per accelerare

la scoperta di contenuti (clustering semantico).

- Ogni peer Tribler

tiene traccia dei contributi degli altri utenti, in termini di banda, tramite

un protocollo chiamato BarterCast [Nota 4] che consente l'identificazione

dei freerider (Adar and Huberman 2000).

- Ogni utente

condivide tramite BarterCast la lista dei peer che gli hanno donato della

banda di upload. Utenti senza preventiva conoscenza reciproca possono così

utilizzare il riscontro ottenuti da utenti da loro conosciuti per valutare

l'affidabilità di ciascun'altro.

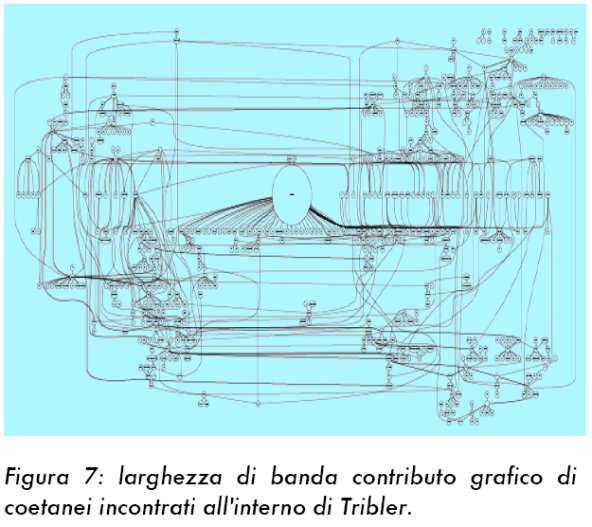

- La figura 7

mostra un grafico di tali contributi di banda trasmissiva così come

sono stati rilevati da un utente del software Tribler.

- Questi dati

sono stati accumulati nel periodo di sei settimane dopo l'introduzione

di BarterCast all'interno di Tribler.

- I 690 nodi in

figura rappresentano dei peer, gli estremi dei trasferimenti di contenuto.

Il grande nodo centrale rappresenta l'utente locale. Il 52 bordi che si

dipartono dal peer locale sono dovute al baratto diretto con 52 peer Tribler.

- L'insieme di

questi bordi forma una rete di fiducia che può essere usata per

stimare la reputazione di un qualunque peer usando algoritmi come PageRank,

EigenTrust, e MaxFlow (Sarkio 2006, Kamvar, Schlosser e Garcia-Molina

2003).

- Ogni utente

Tribler usa questo dato per calcolare, usando l'algoritmo MaxFlow, se un

peer è un possibile freerider. La densità e la copertura

della figura 7 forniscono un'indicazione della forza di questo approccio.

- Nonostante sia

lontano dall'essere perfetto, Tribler è, secondo gli autori, il

più sofisticato approccio correntemente disponibile, rappresentando

un passo avanti rispetto all'approccio di Kazaa e dell'algoritmo tit-for-tat

di Bittorrent, dove l'inefficienza e l'insicurezza di entrambi è

stata in precedenza dimostrata (Piatek et al. 2007).

- Si può

anche notare come Tribler incorpori tutte le caratteristiche cardinali

delle piattaforme P2P e come la purezza accademica dell'architettura non

presenti punti centrali tali da limitare la futura scalabilità del

sistema.

3.8.

Argomenti di ricerca, tendenze, sviluppi futuri

- L'evoluzione

delle piattaforme P2P mostra come la decentralizzazione e la fiducia rappresentino

le due sfide primarie per i ricercatori. Le piattaforme P2P decentralizzate

restano indietro in termini di sofisticazione rispetto agli approcci basati

su servizi web centralizzati.

- Il problema

di base dell'approccio decentralizzato consiste nel trasformare risorse

di calcolo donate, inaffidabili e non sicure in una piattaforma P2P affidabile,

e nel raccogliere informazioni disperse attraverso l'uso di software che

viene eseguito a livello locale.

- L'approccio

decentralizzato, intrinsecamente più complesso, rimane comunque

l'approccio preferito a causa dell'intrinseca scalabilità dei sistemi

decentralizzati. Ad esempio, un servizio centralizzato come Wikipedia richiede

una raccolta continua di donazioni per rimanere operativo [Nota 5].

- È molto

probabile che gli sforzi volti a mantenere la decentralizzazione continueranno,

migliorando allo stesso tempo in termini di sofisticazione.

- La seconda sfida

che ricorre in tutti i casi presentati è la separazione del bene

dal male. Un sistema distribuito per la valutazione della reputazione è

necessario per identificare i buoni prosumer sia in termini di contenuti

contribuiti che di risorse di elaborazione donate (Sarkio 2006, Kamvar,

Schlosser e Garcia-Molina 2003).

- Ciò consentirà

di realizzare significativi guadagni di efficienza e permetterà

alla produzione sociale di svilupparsi ulteriormente.

- Un sistema di

reputazione affidabile potrebbe anche permettere la creazione di una valuta

di scambio dell'Internet e di un mercato di risorse e servizi [Nota

5] in grado di prevenire comportamenti disonesti (Piatek et al.

2007).

- Descriviamo

ora i due principali sviluppi delle piattaforme P2P che saranno pronti

per l'utilizzo in massa nel periodo 2009-2010.

- La prima innovazione

sarà il servizio di Video on Demand in alta definizione (HDTV).

Questo richiederà miglioramenti della seconda funzione cardinale

delle piattaforme P2P (meccanismo di regolamentazione per le risorse del

computer) e una maggiore diffusione dell'accesso Internet ad alta velocità.

- La seconda innovazione

sarà la possibilità di scambiare contenuti in forma anonima

utilizzando una darknet, ovvero un meccanismo volto a vanificare sia la

censura di Internet che l'applicazione della legge sul copyright. Il gruppo

freenetproject.org ha già prodotto una darknet nel 2000, ma questa

era lenta, difficile da usare, e con un'offerta limitata.

- Le darknets

contrastano con la seconda caratteristica cardinale delle piattaforme P2P,

poiché il pieno anonimato ed i costi supplementari per la capacità

trasmissiva si conciliano difficilmente con l'obbligazione nei confronti

degli utenti a contribuire risorse.

- Entro il 2010

le darknets dovrebbero essere in grado di offrire lo stesse prestazioni

del software tradizionale P2P, facendo ricorso a tecniche di social networking,

ed al momento non esistono metodi efficaci tecnologici o legali per fermarle

(Zittrain 2007).

- Tecnologie come

il calcolo sicuro e la gestione dei diritti digitali (DRM) sono già

state considerate inadeguate a contrastare il fenomeno della darknets (Schecter,

Greenstadt and Smith 2003). I pareri sul futuro della produzione sociale

variano da "si tratta di uno scherzo di breve durata" a "l'unione

dei dilettanti soppianterà l'istituto professionale come motrice

della cultura comune" [Nota 7].

- Una causa possibile

per un tale declino potrebbe essere la comparsa di meccanismi monetari

per ricompensare i contributori, ma questo studio non è riuscito

a trovare prove che vadano a suffragare questa opzione. È tuttavia

probabile che entrambi i punti di vista siano corretti. I contributi e

le donazioni di risorse rimarranno volontari, ma genereranno una sorta

di "credito sociale" che potrà essere fatto circolare

ed utilizzato in altri contesti.

- È anche

probabile che una "valuta di Internet" o un "credito sociale"

basato di un robusto sistema di reputazione possano creare un ecosistema

in cui sia i prosumer che il business possano prosperare. Per molti anni

si é assistito ad una crescita continua della produzione di massa

in termini di utilizzo, ampiezza della produzione creativa, sofisticazione,

ed i livelli attuali appaiono essere sostenibili nel corso del tempo.

- Se questa tendenza

continuerà, si può prevedere che la produzione sociale diventerà

il modello creativo trainante dell'Internet entro il 2010-2012.

4.

DISCUSSIONE SU PRODUZIONE SOCIALE, NEUTRALITÀ DELLA RETE E COPYRIGHT

- I casi illustrati

nella sezione precedente hanno fornito dettagli sulla crescita e sull'ulteriore

potenziale dirompente della produzione di massa. Nelle sezioni diamo un'ampia

visione della peer production, collegandola ai precedenti storici sulla

discriminazione di prezzo e sui diritti di proprietà.

4.1.

Convergenza, neutralità della rete, innovazione

- Un'infrastruttura

convergente può essere utilizzata per offrire servizi quali televisione,

voce e dati. La discussione sulla neutralità della rete ruota intorno

al non favorire un servizio o fornitore di servizi rispetto ad un altro,

e sul non introdurre tariffe extra a carico dei provider. In questo dibattito

si trascura spesso la storia della discriminazione di prezzo, che dura

da diversi secoli: Andrew Odlyzko in (Odlyzko 2008) lega numerosi

precedenti storici di discriminazione di prezzo all'attuale dibattito sulla

neutralità della rete, combinandolo con osservazioni generali sul

settore delle telecomunicazioni.

- Questa sezione

estende l'opera citata e la amplia con riflessioni sulla peer production.

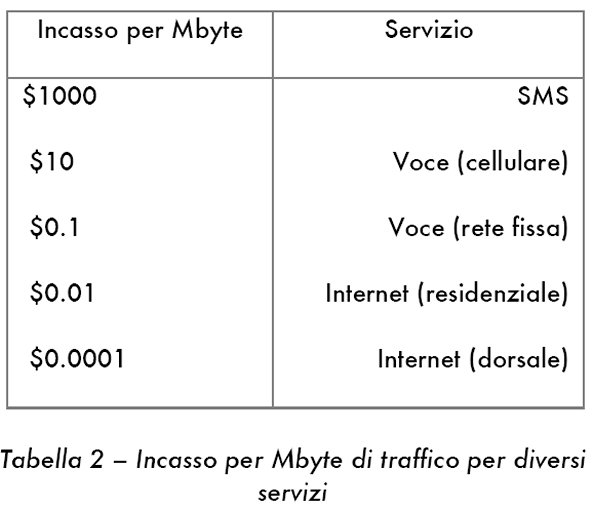

- La chiave della

pratica corrente di discriminazione di prezzo è la Tabella 2,

che mostra il costo finale per diversi servizi di rete.

- Si può

notare come i livelli di prezzo dei servizi di testo (ad es. SMS) eccedano

di diversi ordini di grandezza il costo di trasporto nella dorsale di Internet.

Il mantenimento di questa struttura di prezzo è valutato essenziale

dagli Internet provider. "La lezione chiave è che i fornitori

di servizi tradizionali resistono alla pressione di diventare semplici

gestori di tubi" (Crowcroft 2007).

- Le forze che

guidano l'industria delle telecomunicazioni sembrano voler ripetere i livelli

di profitto associati ai servizi SMS, causando così un triplice

livello di inefficienza. Da una parte

- (1) l'industria

evita di concentrarsi nella sua attività primaria, il fornire servizi

di connettività, e non tiene in considerazione la domanda dei consumatori

in maniera competitiva, investendo miliardi secondo pratiche che spesso

risultano inefficaci,

- (2) sviluppando

nuovi servizi di cui non si sentiva il bisogno e

- (3) tecnologie

per adattare l'infrastruttura di rete alle applicazioni degli utenti.

- La prova della

prima causa di inefficienza è data dal caso del provider Internet

francese Free.fr [Nota 8] . L'industria sostiene che la neutralità

della rete sarebbe di impedimento alla creazione di una rete a banda larga

"terribilmente costosa".

- Tuttavia, le

reti a banda larga possono essere costruite in maniera poco costosa seguendo

la lezione francese. Free.fr offre accesso illimitato ad alta velocità

ad un costo che è una frazione di quello dei competitori, e nonostante

ciò riesce ad ottenere i più elevati ricavi lordi dell'industria

di telecomunicazione dell'Unione Europea.

- I motivi risiedono

nella combinazione di accesso disaggregato alla rete locale (unbundling)

e dark fiber, integrazione verticale, utilizzo di DSLAM propri, struttura

di rete semplice, tariffa flat dirompente di 30 Euro per collegamenti a

28 Mbps, IPTV e chiamate VOIP internazionali illimitate.

- Per contenere

i costi Free.fr costruisce e perfeziona continuamente le proprie set-top

boxes ed ha sviluppato un semplice sistema di billing [Nota 9] .

- La seconda causa

dietro l'inefficienza dell'industria delle telecomunicazioni è il

continuo tentativo di competere con i fornitori di servizi diretti agli

utenti finali usando tecnologia più costosa e meno efficiente, concentrandosi

sulla distribuzione di contenuti secondo il modello client/server ed ignorando

il P2P.

- La mancanza

di innovazioni di successo da parte dell'industria delle telecomunicazioni

relativamente allo sviluppo di servizi per gli utenti finali è stata

analizzata in dettaglio (Odlyzko 2004).

- Essa è

stata incapace di prevedere e sfruttare innovazioni come Youtube e Facebook,

e in aggiunta a ciò, come verificato dal progetto Glasnost [Nota

10] , esistono società come Comcast, Cox ed altre, che bloccano

il traffico P2P.

- Vale la presunzione

secondo la quale l'uso "eccessivo" della banda larga da parte

degli utenti P2P non può non risultare in interferenze ai servizi

forniti agli altri utenti. Anche questo è un esempio dell'incapacitàdell'industria

di comprendere la domanda dei consumatori e di quantificare la capacità

di rete associata.

- Le tre maggiori

fonti di reddito della Tabella 2 sono minacciate dalle innovazioni introdotte

dalle piattaforme P2P. L'offerta di servizi P2P wireless di messaggistica

e voce sta maturando ed è guardata con preoccupazione dall'industria

[Nota 11] .

- I prossimi terminali

duali GSM-Wifi, insieme all'offerta Internet a basso costo dei comuni,

saranno i probabili vincitori di una competizione equa basata sul merito.

- La terza causa

di inefficienza deriva dell'amore dell'industria per le storiche tecnologie

a commutazione di circuito con qualità di servizio predeterminata

ed dal corrispondente risentimento per la commutazione di pacchetto best-effort

dell'era di Internet.

- L'esperienza

dei decenni trascorsi ha indicato che è in generale più economico

adattare le applicazioni alle reti best-effort, piuttosto che costruire

reti intelligenti con qualità di servizio certa.

- La produzione

di massa, la tecnologia P2P, insieme con le reti "stupide", formano

una combinazione naturale in grado di offrire interconnessioni ad altissima

velocità nella dorsale, intelligenza alle estremità e scalabilità

tale da poter servire tutta l'umanità'.

- Studi dettagliati

come (Yuksel et al. 2007) mostrano che l'assicurare risorse sufficienti

ad una rete best-effort attraverso la pratica dell'overprovisioning richiede

più banda trasmissiva di quella richiesta usando "flussi"

(ad es. circuiti) con qualità del servizio garantita.

- Tuttavia, questo

studio, così come altri, non fornisce una modellazione accurata

delle economie ottenibili risparmiando tale frazione della banda trasmissiva.

- L'overprovisioning

potrebbe essere un modello economicamente sostenibile anche con una crescita

consistente del traffico Internet pari al 50-60% annuo [Nota 12]

ed apparati per la qualità del servizio inerentemente più

costosi. In sintesi, optare per una rete "stupida" è probabilmente

una scelta intelligente.

- Il successo

di Free.fr e le pubbliche proteste cui blocchi effettuati da Comcast mostrano

l'efficacia della trasparenza e della concorrenza.

- È un

peccato che alle società sia ancora consentito di pubblicizzare

in maniera ingannevole l'accesso Internet "illimitato" ma vincolato

da politiche di utilizzo che limitano in numero di Gigabyte di traffico

e bloccano il P2P.

- In conclusione,

è molto più probabile che si possa migliorare il benessere

economico attraverso la creazione di una vera e trasparente concorrenza

nei mercati della banda larga e delle telecomunicazioni in generale rispetto

ad operare dei tentativi volti ad assicurare la neutralità della

rete.

4.2.

L'industria dei contenuti, i diritti d'autore, e le licenze obbligatorie

- È molto

probabile che la produzione sociale forzerà una trasformazione dell'industria

dei contenuti. Questa industria è sotto attacco da quattro direzioni:

- 1) L'erosione

delle fondamenta del copyright

- 2) Il lato pirata

della produzione di massa

- 3) Il cambiamento

delle abitudini rispetto al copyright

- 4) Il progresso

delle darknets.

- Lo sviluppo

della produzione sociale ed analisi storiche dettagliate stanno minando

la giustificazione economica delle vigenti leggi sul copyright.

- La visione dominante

è che la mancanza di tutele legislative per i prodotti culturali

risulterebbe in fallimento del mercato e sottoproduzione: nonostante ciò

la produzione di massa sta sostituendo in maniera crescente il concetto

di bene comune a quello di proprietà privata, offrendo una ricca

scelta di prodotti competitivi.

- Un'analisi 1.000

anni di storia della recinzione dei terreni e del concetto di beni comuni

rivela che il diritto ad essere inclusi nel flusso dei benefici nuoce all'innovazione

ed ha recentemente assunto un'importanza secondaria (Ford Runge e Defrancesco

2006).

- Un'analisi economica

ha rivelato che la legislazione della UE contiene tre assunti che non sono

più validi (Towse 2005). Questi si basano sull'idea che non

possa esistere conflitto di interessi tra autori ed editori, che solo gli

editori siano in grado si sviluppare imprenditorialità, e che l'innovazione

nasca dalle imprese e non dai creatori.

- Il valore aggiunto

degli editori sta oggi diminuendo a causa delle piattaforme P2P, poiché

ogni creatore di talento può raggiungere senza intermediari un pubblico

di milioni di persone, sperimentando nuovi modelli di business. La Figura

2 e le opere associate (Byers et al. 2004) mostrano come opere

coperte da copyright siano ampiamente disponibili attraverso il P2P.

- Questo è

un fattore trainante dell'espansione della legge statunitense sul copyright,

una legge sbilanciata a favore dei gruppi industriali detentori di diritti

d'autore, che la hanno sostanzialmente scritta per proteggere i propri

interessi (Samuelson 2007).

- La proposta

di uno "Zar del copyright" a livello della Casa Bianca non potrebbe

che espandere ulteriormente la legislazione vigente (Ahrens 2008),

aumentando la disconnessione con il mondo reale, dove, ad esempio, più

di un terzo dei PC a livello mondiale sono equipaggiati con un client P2P

[Nota 13] .

- Le nuove azioni

legali intentate negli Stati Uniti contro gli utenti del P2P, ed il recente

riconoscimento di 111 milioni di dollari di risarcimento nel caso "Torrentspy"

indicano quanto le prospettive legali siano distanti da quelle degli utenti

comuni.

- Il supporto

per questo tipo di leggi va così erodendosi: uno studio su un campione

di più di 6000 persone in Finlandia ha dimostrato come la pena massima

prevista per la condivisione di file non corrisponda al "senso di

giustizia" dei partecipanti [Nota 14].

- Entro il 2010

le leggi sul copyright risulteranno completamente inapplicabili a causa

dell'uso di massa della condivisione di file P2P, della mancanza di contromisure

efficaci e della disponibilità di darknets (sezione 3.8).

- In futuro la

scelta verterà tra la protezione di modelli di business in via di

fallimento, introducendo leggi e meccanismi di repressione più severi,

o la legalizzazione delle pratiche correnti, depenalizzando i comportamenti

di milioni di persone.

- L'esperienza

del P2P mostra la necessità di scegliere la seconda opzione, esplorando

allo stesso tempo nuovi modelli di business che siano sostenibili e compatibili

con l'era di Internet. Il P2P potrebbe essere legalizzato per l'utilizzo

senza scopo di lucro da parte dei prosumer attraverso la creazione di un

diritto di redistribuzione digitale, combinato con uno schema di licenza

obbligatoria ed al pagamento di un diritto d'autore.

- Alcuni schemi

per la licenza obbligatoria sono esaminati in (Gervais 2003). In

molti concordano sulla necessità di riformare le leggi sul copyright

(Samuelson 2007), reintroducendo il diritto di proprietà

condivisa (Ford Runge and Defrancesco 2006). È auspicabile

che la produzione di massa possa prosperare ulteriormente e che le leggi

ed i modelli di business subiscano un'evoluzione, ponendo fine a questo

periodo di "far west".

- Sfortunatamente

è anche possibile che le industrie dei contenuti e delle telecomunicazioni

decidano di unire le forze per fermare l'innovazione ai bordi della rete

attraverso il blocco dei concorrenziali servizi P2P, utilizzando le stesse

tecniche di ispezione dei pacchetti usate da alcuni governi per mantenere

l'Internet "pulita", ed attraverso il perseguimento di cause

legali.

5.

CONCLUSIONE

- In questo articolo

abbiamo delineato l'evoluzione della produzione di massa distribuita sull'Internet,

con il supporto di dati sperimentali ed analisi empiriche.

- Questa evoluzione

ha avuto inizio nel 1997, con il sito web Slashdot.com, in cui è

stato osservato che i commenti degni di nota sono riconosciuti come tali

dalla comunità degli utenti in meno di un'ora. Con Youtube.com il

concetto di video generati dagli utenti ha acquisito una primaria importanza,

portando agli estremi il concetto di "amicizia" in rete, dove,

ad esempio, i 10 utenti più popolari di Youtube raccolgono insieme

72.866 amici.

- Lo studio accurato

di questi sviluppi tecnologici ci porta a pensare che le caratteristiche

cardinali delle piattaforme per la produzione di massa (piattaforme P2P)

siano:

- separazione

tra contributi buoni e cattivi,

- regolazione

delle risorse,

- comunicazione

di gruppo e

- costruzione

comunitaria.

- Le misure incluse

in questo articolo mostrano come la produzione di massa stia crescendo

in termini di utilizzo, produzione creative, sofisticazione e ampiezza.

- Il più

ampio studio accademico finora disponibile sul lato pirata della produzione

di massa mostra che opere coperte da copyright sono ampiamente disponibili

sulla rete e che l'applicazione delle leggi sul diritto d'autore rischia

di diventare impossibile entro il 2010.

- L'evoluzione

della produzione di massa mostra che creazione di valore ed innovazione

si spostano sempre più dalle industrie dei contenuti e delle telecomunicazioni

verso i bordi della rete.

- Le fonti di

introito correnti di entrambe le industrie saranno difficili da proteggere

e mantenere. La scorsa decade ha mostrato la forza aggregata di volontari

auto-gestiti e di formazioni gerarchiche ma flessibili basate sul merito.

- È probabile

che la prossima decade ci mostrerà una crescita ulteriore, mentre

iniziamo a comprendere come sia possibile organizzare milioni di persone

in un'entità collettiva pienamente autogovernata.

|

![]()

![]()

![]()

![]()

![]()